Hackers vs. IA: La Batalla de los Genios

¿Quién ganará la épica batalla por la supremacía cibernética?

¿La inteligencia artificial con sus algoritmos avanzados o el ingenio humano de un hacker ético?

Hablamos con Pedro, responsable del área de hacking ético conocido por sus travesuras constructivas e Inés, responsable del área de Ciber IA y gestión del dato que debaten sobre el impacto de la IA en la ciberseguridad y sus vulnerabilidades.

¿Cómo ha transformado la inteligencia artificial el campo de la ciberseguridad en los últimos años?

Inés: La IA ha cambiado el paradigma general, no solo en el campo de la ciberseguridad. Los algoritmos avanzados y el aprendizaje automático hacen mucho más fácil la detección de patrones y el análisis de un volumen de datos mucho más grande. Si nos centramos en el campo de la ciberseguridad, la IA permite realizar análisis de comportamientos, reducir los falsos positivos, crear escenarios de simulación de incidentes, … Se está convirtiendo en una herramienta complementaria muy poderosa para el análisis de nuestras infraestructuras. Aunque bien es cierto que ha supuesto una mejora, no debemos de olvidar que en ocasiones los modelos de IA funcionan como los minions, son una ayuda, pero hay veces que responden de manera torpe y no está de más su supervisión.

Pedro: La IA mola, no te lo voy a negar, sabe un montón de cosas…pero aquí lamentablemente se aplica la premisa de que el conocimiento no equivale a la sabiduría. También debemos dejar claro que lo que últimamente se ha puesto de moda son los modelos del lenguaje, y precisamente estos ya no requieren saber complejos comandos para hacer que funcionen de forma anómala…basta con saber comerles el tarro como cuando convences a tu sobrina de que suelte el mando de la PS5 “porque no es bueno jugar tanto” para meterte una viciada de 14 horas en cuanto ella deja de mirarte.

¿Cuáles son las vulnerabilidades más críticas en los sistemas de IA y cómo se pueden en enfrentar?

Inés: La lista es larga, creo que su democratización ha hecho olvidar que su uso (como el de cualquier tecnología) puede conllevar un riesgo.

Por ejemplo, una de las principales vulnerabilidades a la que nos enfrentamos es el sesgo en los datos. Si la IA se entrena con datos sesgados, es decir, que no son completamente representativos del mundo real, puede tomar decisiones erróneas fácilmente. Para enfrentarlo, tenemos que ser muy cuidadosos con la selección y el procesamiento de datos. Además, la seguridad del propio modelo de IA es crucial, si alguien puede manipular el modelo, puede causar estragos.

Pedro: Hay vulnerabilidades de toda índole, precisamente los modelos del lenguaje nos permiten jugar con el léxico con el objetivo de alterar su funcionamiento para obtener ciertos comportamientos. Ya sea para que nos de datos que los desarrolladores han intentado ocultar, funcione de una forma absurda inventando datos o adopte la personalidad de un apicultor adicto al fentanilo, las anomalías que podemos aprovechar mediante esa picaresca de las palabras (muy nuestra, por cierto) son bastantes.

Parece que la colaboración entre hackers éticos y desarrolladores de IA es crucial. ¿Qué tan importante es esta colaboración para fortalecer la seguridad? ¿Cómo se puede fomentar en la industria?

Inés: Es absolutamente esencial. Trabajar juntos en equipos multidisciplinares nos permite identificar y solucionar problemas más fácilmente antes de que los ciberdelincuentes los exploten.

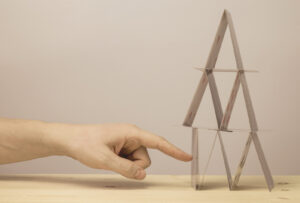

Pedro: Siempre es divertido colaborar con otros especialistas. Sobre todo, cuando el trabajo que tiene tu compañero es construir cuidadosos castillos de naipes y el tuyo es darle un manotazo a ver si se cae. Obviamente yo estoy en el lado divertido de los naipes.

Por último, pero no menos importante, hablemos del futuro. ¿Qué innovaciones en inteligencia artificial esperáis que redefinan la ciberseguridad en los próximos años?

Inés: Creo que el aprendizaje federado tendrá un mayor auge y un papel fundamental en la privacidad de los datos. Este aprendizaje permite entrenar modelos de IA sin compartir datos sensibles, haciendo que no se vea comprometida la privacidad de los datos o al menos, que no sea por el entrenamiento de modelos. Lo que sí que tengo claro, visto el crecimiento que está teniendo la IA en estos últimos años, es que puede aparecer un algoritmo o un modelo nuevo que haga factibles cosas que ahora no nos planteamos.

Pedro: El estado del arte está un poco verde todavía como con cualquier tecnología incipiente. No me cabe duda que los modelos evolucionarán y aparecerán sistemas de seguridad que los protejan de una forma más eficiente. En mi opinión el problema no está en los modelos si no en los conjuntos de datos usados para el entrenamiento. Si el modelo no tiene datos de origen adaptados a prevenir estos comportamientos maliciosos, seguiremos pudiendo hackearlos. Es un campo interesante y por mi parte tengo curiosidad por ver en que desemboca todo.

Somos una compañía especializada en Seguridad, Ciberseguridad e Inteligencia empresarial, que mediante los últimos avances tecnológicos, garantizamos la seguridad y confianza que nuestros clientes necesitan.